クローラーとは、検索エンジンの一部として、インターネット上のウェブページを巡回し、情報を収集するプログラムのこと。SEOを考えるうえで、クローラーの仕組みや基本的な役割を理解する必要があります。

この記事では、クローラーはどのような動作をし、どのようにSEOに影響を与えるのか、またクローラビリティを向上させるためのポイントを詳しく解説します。

目次

クローラーとは

クローラーとは、検索エンジンがインターネット上のコンテンツを効率的に収集するためのボットのこと。クローラーはウェブページを巡回し、その情報を検索エンジンのデータベースに保存します。このデータベースをもとに、ユーザーが検索エンジンでキーワード検索を行った際に、適切な検索結果を表示することができます。

クローラーの種類

世界中にはいくつものクローラーが存在しますが、まずはおさえておきたいクローラーを3つ紹介します。

| 検索エンジン | クローラー |

|---|---|

| Googlebot | |

| Bing | Bingbot |

| Yahoo! | Yahoo! Slurp |

とくに、Googleは世界で80%以上のシェアを獲得しているため、はじめのステップでは、Googlebotを意識するとよいでしょう。

検索エンジンの仕組みとクローラーの関係

検索エンジンの基本的な役割は、インターネット上の情報を整理してユーザーに提供することです。そのために、検索エンジンはクローラーを使用してウェブページを巡回し、データを収集します。クローラーがウェブサイトを巡回することを「クロールする」と表現し、集めた情報をデータベースに保管することを「インデックス」といいます。

インデックスされたページは、ユーザーが検索を行った際に適切な結果を表示するための基礎データとなり、検索結果を表示する順番をランキング付けします。この仕組みの中で、SEO対策は重要な役割を果たします。適切なクローリング対策を行うことで、クローラーに効率よくウェブページの情報を伝えることができ、結果として検索順位が向上します。

検索エンジンがクローラーを使う理由

検索エンジンがクローラーを使う理由は、ウェブ上に存在する膨大な情報を効率的に整理し、ユーザーに適切な結果を提供するためです。検索エンジンは、ユーザーが特定のキーワードで検索を行った際に、関連性の高いウェブページを迅速かつ正確に表示する必要があります。そのために、クローラーがウェブページを巡回し、ページの内容を収集・インデックスするプロセスが必要です。

また、クローラーはウェブ上のリンクを辿ってページを発見し、新しいページや更新されたページの情報を収集します。これにより、検索エンジンは常に最新の情報を持ち続けることができ、ユーザーにタイムリーな情報を提供できます。

クローラーにサイトを発見してもらう方法

クローラーがサイト内を巡回しやすくすることをクローラビリティといいます。ウェブサイトを運営するうえで、このクローラビリティを向上させることが重要です。以下で、具体的な対策方法を7つ解説します。

(1)XMLサイトマップの作成と送信

XMLサイトマップとは、検索エンジンにクロールしてほしい、重要なページを伝えるためのファイルのこと。いわば検索エンジンに向けたウェブサイトの案内図のようなものです。そのため適切に作成することでクローラーが巡回しやすくなります。

(2)パンくずリストの設定

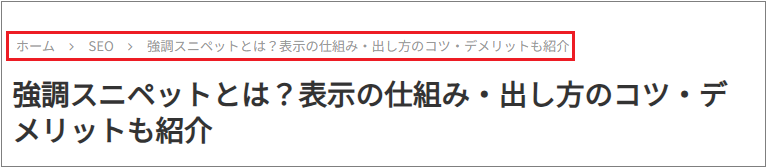

パンくずリストとは、サイトに訪れたユーザーが、どこにいるのかを分かりやすくするためのナビゲーション機能です。例えば「ホーム>SEO>強調スニペットとは」のように、ページの上部に設置され、サイト内の階層を視覚的にリンク付きで表示します。

クローラーはリンクをたどってサイトを巡回しているため、このパンくずリストを設定することで、検索エンジンがサイト内のページの関係性を理解しやすくなります。また、ユーザーがサイト内をスムーズに移動できるようになるという利点もあり、クローラーとユーザーの両方の手助けとなります。

(3)内部リンクの最適化

内部リンクとは、同じウェブサイト内で関連するページ同士をリンクさせることです。内部リンクの最適化は、クローラーがウェブページを効率的に巡回し、関連するページを発見する手がかりとなります。

また、適切な内部リンクによって、ユーザーエクスペリエンスも向上し、複数のページの閲覧を促進することができます。ユーザーとクローラーの両方に、サイト全体の巡回を促すことができるため、SEOの観点でも重要視されています。

(4)robots.txtの設定

robots.txtとは、検索エンジンに収集されたくないコンテンツをクロールされないように制御するファイルのことです。クロールの対象から除外したいページを指定できるため、クロール効率を向上させることが可能です。ただし、robots.txtの内容はだれでも確認できるため、設定には注意が必要です。

(5)ページの表示速度の改善

表示速度が遅いとクローラーがページを巡回する際に時間がかかり、結果としてインデックスが遅れる可能性があります。

速度が遅くなる原因には、画像ファイルのサイズが最適化されていないこと、JavaScriptやCSSファイルの容量が大きいこと、サーバーの応答が遅いことなどが挙げられます。各要因を一つずつ確認して修正し、ページの表示速度を向上させましょう。

(6)URLを正規化する

URLの正規化とは、異なるURLが同じコンテンツを指す際に、一つの標準的なURLに統一することを指します。これにより、同一のコンテンツが複数のURLでインデックスされることを防ぎます。

例えば、複数のパラメータが付加される場合や、サイトの運営方法によって異なるURLが生成され、意図しないページが正規URLとして評価されることがあります。この場合、同じコンテンツであっても、検索エンジンは別の記事と判断するため評価が分散してしまいます。

そのため、301リダイレクトやcanonicalタグを使用し対処しましょう。

(7)サイト構造の改善

複雑で不明瞭な構造は、クローラーがページを見つけにくくなるため、サイト全体のパフォーマンスにも影響します。

サイト構造は、階層構造を明確にし、重要なページへのリンクをトップページやカテゴリーページから適切に配置することがポイントです。例えば、大手ECサイトでは製品カテゴリ、さらにそのサブカテゴリといった階層構造を整備し、ユーザーがスムーズに移動できるように工夫されています。

クローラーの巡回を確認する方法

最後に実際にクロールされているかを確認する方法を紹介します。

Search Consoleで検索

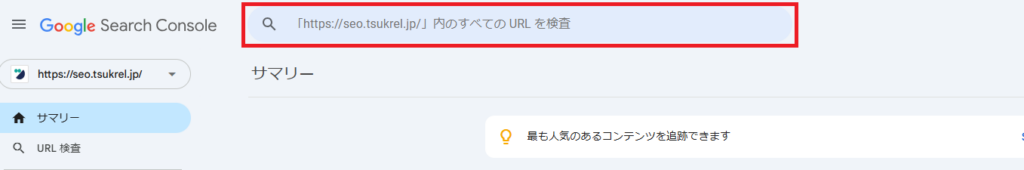

Search Consoleでは、特定のウェブページ単位でクロールされたタイミングを見ることができます。

手順は簡単です。まず、Search Consoleの左上「URL検査」のところに、URLを入力し検索します。

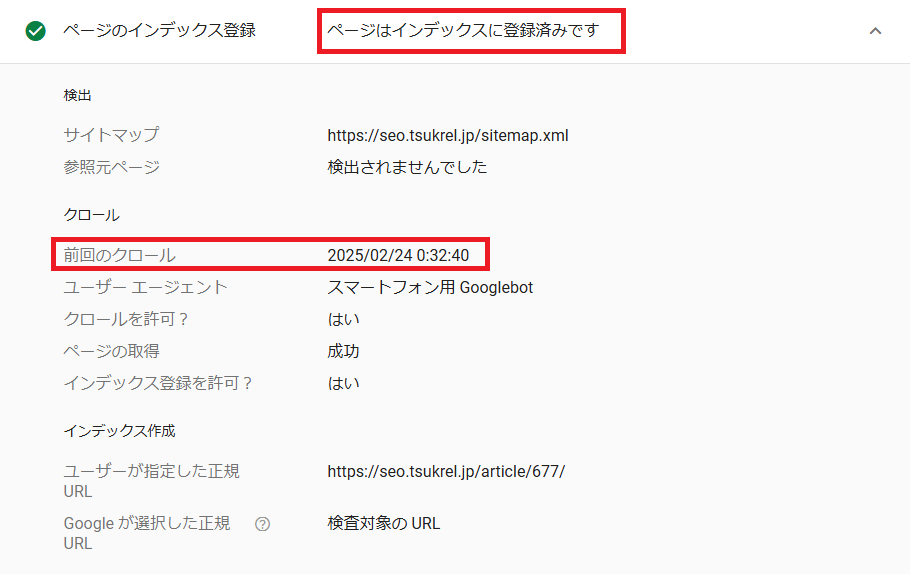

サイトが登録されている場合には、「ページはインデックスに登録済みです」と表示されます。ここを押すと前回のクロール状況を確認できます。

確認した際に、クロールの間隔が空いていれば、なにかしらの問題がある可能性があります。記事を更新し、クロールのリクエストを行ってみましょう。

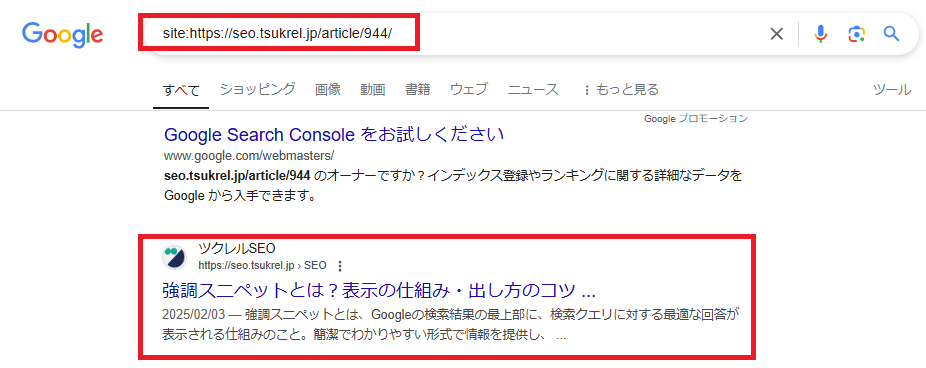

「site:」で検索

「site:」コマンドを使用し、検索エンジンの検索バーに「site:サイトURL」を入力して検索すると、インデックス済みのページを確認することができます。検索ボタンを押してもウェブページが表示されない場合にはクロールやインデックスが行われていません。そのため、必要な修正や改善を行う必要があります。

クローラーを理解してSEOを最適化しよう

クローラーの基本的な役割は、インターネット上のウェブページを巡回し、情報を収集すること。そのためには、記事内で紹介したような、robots.txtファイルやXMLサイトマップなどの設定に加え、「質」の高い記事を効率的に制作していくことも大切です。

マイナビが提供する「ツクレルSEO」は、SEOコンテンツに特化したAIライティングツールです。キーワードを入力すると、共起語やユーザーニーズ、競合調査などをAIが自動で実施。そして、それらをもとに適切な記事構成や本文を生成します。

クローラーがスムーズにサイトをクロールするために、SEO対策は重要な要素となります。記事制作において、AIツールを活用してコンテンツの最適化を行うことで、検索エンジンの順位を効果的に向上させることができます。

(ツクレルSEO編集部)

※画像はイメージです